Правильний robots.txt створення та налаштування WordPress і Joomla

Добрий день, дорогі друзі! Всі ви знаєте, що пошукова оптимізація – справа відповідальна і тонке. Потрібно враховувати абсолютно кожну дрібницю, щоб отримати прийнятний результат.

Сьогодні ми поговоримо про robots.txt – файлі, який знайомий кожному вебмайстру. Саме в ньому прописуються всі самі основні інструкції для пошукових роботів. Як правило, вони із задоволенням йдуть запропонованим вказівками та у разі неправильного складання відмовляються від індексації веб-ресурсу. Далі я розповім вам про те, як складати правильний варіант robots.txt, а також про те, як його налаштувати.

Зміст

- Для чого призначений?

- Створення robots.txt

- Директиви

- Налаштування

- Robots.txt для WordPress

- Robots.txt для Joomla

- Помилки при налаштуванні

- Як перевірити файл?

- Висновок

Для чого призначений?

У передмові я вже описав, що це таке. Тепер розповім, навіщо він потрібен. Robots.txt – невеликий текстовий файл, який зберігається в корені сайту. Він використовується пошуковими системами. В ньому чітко прописані правила індексації, тобто які розділи сайту потрібно індексувати (додавати у пошук), а які – ні.

Зазвичай від індексації закриваються технічні розділи сайту. Зрідка у чорний список потрапляють неунікальні сторінки (копіпаст політики конфіденційності тому приклад). Тут же “роботам пояснюються” принципи роботи з розділами, які потрібно індексувати. Дуже часто прописують правила для декількох роботів окремо. Про це ми і поговоримо далі.

При правильному налаштуванні robots.txt ваш сайт гарантовано зросте в позиціях пошукових систем. Роботи будуть враховувати тільки корисний контент, обділяючи увагою дубльовані або технічні розділи.

Створення robots.txt

Щоб створити файл, достатньо скористатися стандартним функціоналом вашої операційної системи, після чого вивантажити його на сервер через FTP. Де він лежить (на сервері), здогадатися нескладно – в корені. Зазвичай ця папка називається public_html.

Ви без праці зможете потрапити в неї з допомогою будь-якого FTP-клієнта (наприклад, FileZilla) або вбудованого файлового менеджера. Природно, ми не будемо завантажувати на сервер порожній роботс. Впишемо туди кілька основних директив (правил).

User-agent: *

Allow: /

Використовуючи ці рядки у своєму файлі robots, ви звернетеся до всіх роботам (директива User-agent), дозволивши їм індексувати ваш сайт цілком і повністю (включаючи всі тех. сторінки Allow: /)

Звичайно ж, такий варіант нам не дуже підходить. Файл буде не особливо корисний для оптимізації під пошукові системи. Він безумовно має потребу в грамотній настройці. Але перед цим ми розглянемо всі основні директиви і значення robots.txt.

Директиви

| User-agent | Одна з найважливіших, оскільки вказує яким роботам слідувати йдуть після неї правилами. Правила враховуються до наступного User-agent в файлі. |

| Allow | Дозволяє індексацію будь-яких блоків ресурсу. Наприклад: “/” або “/tag/”. |

| Disallow | Навпаки, забороняє індексацію розділів. |

| Sitemap | Шлях до карти сайту (у форматі xml). |

| Host | Головне дзеркало (з www або без, або якщо у вас кілька доменів). Тут же вказується захищений протокол https (при наявності). Якщо у вас стандартний http, його вказувати не потрібно. |

| Crawl-delay | З її допомогою ви зможете встановити інтервал відвідування і завантаження файлів вашого сайту для роботів. Допомагає знизити навантаження на хост. |

| Clean-param

|

Дозволяє відключити індексацію параметрів на тих чи інших сторінках (за типом www.site.com/cat/state?admin_id8883278). На відміну від попередніх директив, тут вказуються 2 значення (адреса і сам параметр). |

Це все правила, які підтримуються флагманськими пошуковими системами. Саме з їх допомогою ми будемо створювати наш роботс, оперуючи різними варіаціями для самих різних видів сайтів.

Налаштування

Для грамотної настройки файлу роботів нам потрібно точно знати, які з розділів сайту повинні бути проіндексовані, а які – ні. У випадку з простим одностраничником на html + css нам достатньо прописати кілька основних директив, таких як:

User-agent: *

Allow: /

Sitemap: site.ru/sitemap.xml

Host: www.site.ru

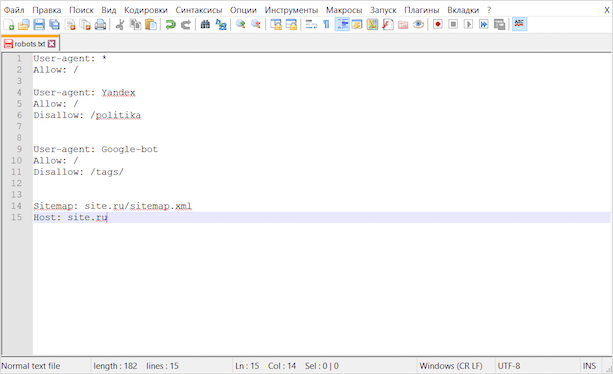

Тут ми вказали правила та значення для всіх пошукових систем. Але краще додати окремі директиви для Гугла і Яндекса. Виглядати це буде так:

User-agent: *

Allow: /

User-agent: Yandex

Allow: /

Disallow: /politika

User-agent: GoogleBot

Allow: /

Disallow: /tags/

Sitemap: site.ru/sitemap.xml

Host: site.ru

Тепер на нашому html-сайті будуть індексуватися абсолютно всі файли. Якщо ми хочемо виключити якусь сторінку або зображення, то нам необхідно вказати відносну посилання на цей фрагмент у Disallow.

Ви можете використовувати сервіси автоматичної генерації файлів роботс. Не гарантую, що з їх допомогою ви створите ідеально правильний варіант, але в якості ознайомлення можна спробувати.

Серед таких сервісів можна виділити:

- PR-CY,

- htmlweb.

З їх допомогою ви зможете створити robots.txt в автоматичному режимі. Особисто я вкрай не рекомендую цей варіант, тому що набагато простіше зробити це вручну, налаштувавши під свою платформу.

Говорячи про платформах, я маю на увазі всілякі CMS, фреймворки, SaaS-системи і багато іншого. Далі ми поговоримо про те, як настроювати файл роботів WordPress і Joomla.

Але перед цим виділимо декілька універсальних правил, якими можна керуватися при створенні і налагодженні роботс майже для будь-якого сайту:

Закриваємо від індексування (Disallow):

- адмінку сайту;

- особистий кабінет і сторінки реєстрації/авторизації;

- кошик, дані з форм замовлень (для інтернет-магазину);

- папку cgi (розташовується на хості);

- службові розділи;

- скрипти ajax, json;

- UTM і Openstat-мітки;

- різні параметри.

Відкриваємо (Allow):

- картинки;

- JS і CSS-файли;

- інші елементи, які повинні враховуватися пошуковими системами.

Крім цього, в кінці не забуваємо вказати дані sitemap (шлях до карти сайту) і host (головне дзеркало).

Robots.txt для WordPress

Для створення файлу нам потрібно точно так само закинути robots.txt в корінь сайту. Змінювати його вміст в такому разі можна буде за допомогою все тих же FTP і файлових менеджерів.

Є і більш зручний варіант – створити файл з допомогою плагінів. Зокрема, така функція є у Yoast SEO. Правити роботс прямо з адмінки куди зручніше, тому сам я використовую саме такий спосіб роботи з robots.txt.

Як ви вирішите створити цей файл – справа ваша, нам важливіше зрозуміти, які саме директиви там повинні бути. На своїх сайтах під управлінням WordPress використовую такий варіант:

User-agent: * # правила для всіх роботів, за винятком Гугла і Яндекса

Disallow: /cgi-bin # папка зі скриптами

Disallow: /? # параметри запитів з домашньої сторінки

Disallow: /wp – файли # самої CSM (з приставкою wp-)

Disallow: *?s= #

Disallow: *&s= # все, що пов’язано з пошуком

Disallow: /search/ # /

Disallow: /author/ # архіви авторів

Disallow: /users/ # і користувачів

Disallow: */trackback # повідомлення від WP про те, що на вас хтось посилається

Disallow: */feed # фід в xml

Disallow: */rss # і rss

Disallow: */embed # вбудовані елементи

Disallow: /xmlrpc.php # WordPress API

Disallow: *utm= # UTM-мітки

Disallow: *openstat= # Openstat-мітки

Disallow: /tag/ # теги (при наявності)

Allow: */uploads # відкриваємо завантаження (картинки і т. д.)

User-agent: GoogleBot # для Гугла

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/

Allow: */uploads

Allow: /*/*.js # відкриваємо JS файли

Allow: /*/*.css # і CSS

Allow: /wp-*.png # і картинки у форматі png

Allow: /wp-*.jpg #

Allow: /wp-*.jpeg # і в інших форматах

Allow: /wp-*.gif # /

Allow: /wp-admin/admin-ajax.php # працює разом з плагінами

User-agent: Yandex # для Яндекса

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: /tag/

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # чистимо UTM-мітки

Clean-Param: openstat # і про Openstat не забуваємо

Sitemap: # прописуємо шлях до карти сайту

Host: https://site.ru # головне дзеркало

Увага! При копіюванні рядків у файлі – не забудьте видалити всі коментарі (текст після #).

Такий варіант robots.txt найбільш популярний серед вебмайстрів, які використовують WP. Ідеальний він? Немає. Ви можете спробувати щось додати або навпаки прибрати. Але врахуйте, що при оптимізації текстовика роботів нерідкі помилки. Про них ми поговоримо далі.

Robots.txt для Joomla

І хоча в 2018 Joomla рідко хто використовує, я вважаю, що не можна обділяти увагою цю чудову CMS. При просуванні проектів на Joomla вам неодмінно доведеться створювати файл роботс, а інакше як ви хочете закривати від індексації непотрібні елементи?

Як і в попередньому випадку, ви можете створити файл вручну, просто закинувши його на хост, або ж використовувати модуль для цих цілей. В обох випадках вам доведеться його грамотно налаштувати. Ось так буде виглядати правильний варіант для Joomla:

User-agent: *

Allow: /*.css?*$

Allow: /*.js?*$

Allow: /*.jpg?*$

Allow: /*.png?*$

Disallow: /cache/

Disallow: /*.pdf

Disallow: /administrator/

Disallow: /installation/

Disallow: /cli/

Disallow: /libraries/

Disallow: /language/

Disallow: /components/

Disallow: /modules/

Disallow: /includes/

Disallow: /bin/

Disallow: /component/

Disallow: /tmp/

Disallow: /index.php

Disallow: /plugins/

Disallow: /*mailto/

Disallow: /logs/

Disallow: /component/tags*

Disallow: /*%

Disallow: /layouts/

User-agent: Yandex

Disallow: /cache/

Disallow: /*.pdf

Disallow: /administrator/

Disallow: /installation/

Disallow: /cli/

Disallow: /libraries/

Disallow: /language/

Disallow: /components/

Disallow: /modules/

Disallow: /includes/

Disallow: /bin/

Disallow: /component/

Disallow: /tmp/

Disallow: /index.php

Disallow: /plugins/

Disallow: /*mailto/

Disallow: /logs/

Disallow: /component/tags*

Disallow: /*%

Disallow: /layouts/

User-agent: GoogleBot

Disallow: /cache/

Disallow: /*.pdf

Disallow: /administrator/

Disallow: /installation/

Disallow: /cli/

Disallow: /libraries/

Disallow: /language/

Disallow: /components/

Disallow: /modules/

Disallow: /includes/

Disallow: /bin/

Disallow: /component/

Disallow: /tmp/

Disallow: /index.php

Disallow: /plugins/

Disallow: /*mailto/

Disallow: /logs/

Disallow: /component/tags*

Disallow: /*%

Disallow: /layouts/

Host: site.ru # не забудьте тут поміняти адресу на свій

Sitemap: site.ru/sitemap.xml # і тут

Як правило, цього достатньо, щоб зайві файли не потрапляли в індекс.

Помилки при налаштуванні

Дуже часто люди допускають помилки при створенні та налаштування файлу роботс. Ось найбільш часто зустрічаються з них:

- Правила вказані тільки для User-agent.

- Відсутні Host і Sitemap.

- Наявність http-протоколу, в директиві Host (потрібно вказувати лише https).

- Недотримання правил вкладеності при відкритті/закритті картинок.

- Не закриті UTM і Openstat-мітки.

- Прописування директив host і sitemap для кожного робота.

- Поверхнева проробка файлу.

Дуже важливо правильно налаштувати цей маленький файлик. При допущення грубих помилок ви можете втратити значну частину трафіку, тому будьте гранично уважні при налаштуванні.

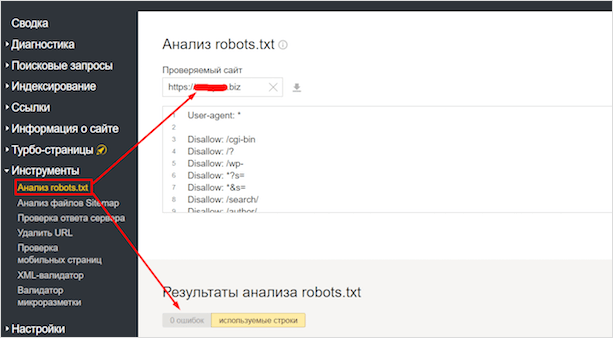

Як перевірити файл?

Для цих цілей краще використовувати спеціальні сервіси від Яндекс і Google, т. до. ці пошукові системи є найбільш популярними й затребуваними (найчастіше єдино використовуваними), такі пошуковики як Bing, Yahoo або Rambler розглядати немає сенсу.

Для початку розглянемо варіант з Яндексом. Заходимо в Вебмастер. Після чого в Інструменти – Аналіз robots.txt.

Тут ви зможете перевірити файл на помилки, а також перевірити в реальному часі, які сторінки відкриті для індексації, а які – ні. Дуже зручно.

У Гугла є точно такий же сервіс. Йдемо в Search Console. Знаходимо вкладку Сканування, вибираємо Інструмент перевірки файлу robots.txt.

Тут точно такі ж функції, як і у вітчизняному сервісі.

Зверніть увагу, що він показує мені 2 помилки. Пов’язано це з тим, що Гугл не розпізнає директиви очищення параметрів, які я вказав для Яндекса:

Clean-Param: utm_source&utm_medium&utm_campaign

Clean-Param: openstat

Звертати увагу на це не варто, т. к. роботи Google використовують тільки правила для GoogleBot.

Висновок

Файл robots.txt дуже важливий для SEO-оптимізації вашого сайту. Підходите до його налаштуванні з усією відповідальністю, тому як при неправильній реалізації все може піти прахом.

Враховуйте всі інструкції, якими я поділився у цій статті, і не забувайте, що вам не обов’язково точнісінько копіювати мої варіанти роботс. Цілком можливо, що вам доведеться додатково розбиратися в кожній з директив, підлаштовуючи файл під свій конкретний випадок.

А якщо ви хочете більш глибоко розібратися в robots.txt і створення сайтів на WordPress, то я запрошую вас на курс Василя Блінова “Як створити блог”. На ньому ви дізнаєтеся, як можна без особливих зусиль створити сайт, не забувши оптимізувати його для пошуковиків.